ICASSP(International Conference on Acoustics, Speech and Signal Processing)即国际声学、语音与信号处理会议,是IEEE主办的全世界最大的,也是最全面的信号处理及其应用方面的顶级会议,在国际上享有盛誉并具有广泛的学术影响力。

小米AI实验室被录用的论文内容涉及语音翻译、量化、快速解码、说话人识别、关键词识别等诸多方向,在此次 ICASSP 2023录用的论文概述如下。

01

▍Rethinking the Reasonability of the Test Set for Simultaneous Machine Translation

Mengge Liu,Wen Zhang,Xiang Li,Jian Luan,Bin Wang,Yuhang Guo,Shuoying Chen

【业务应用】

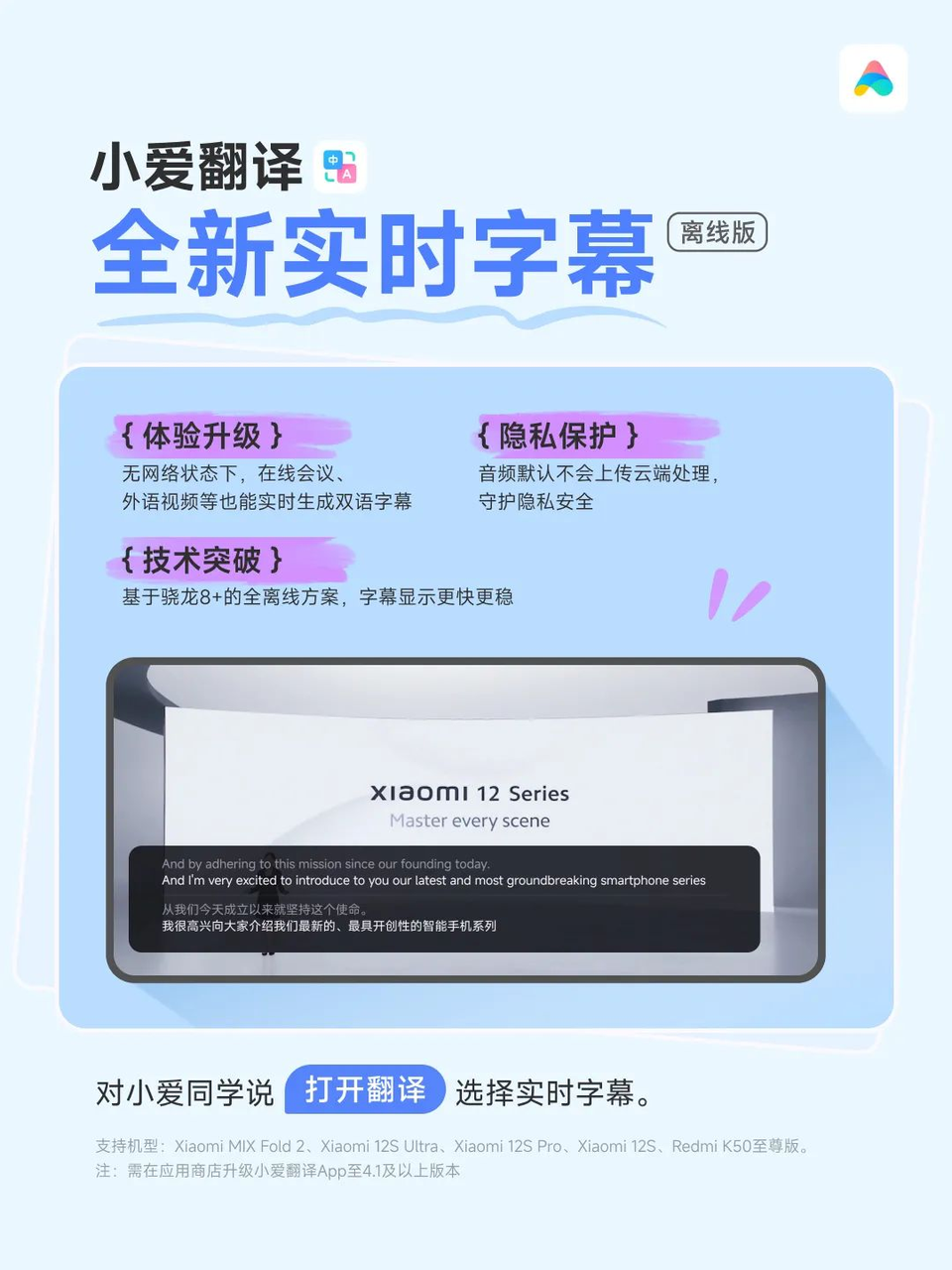

小爱翻译实时字幕:在小爱翻译实时字幕和同声传译研发过程中用于评测质量。

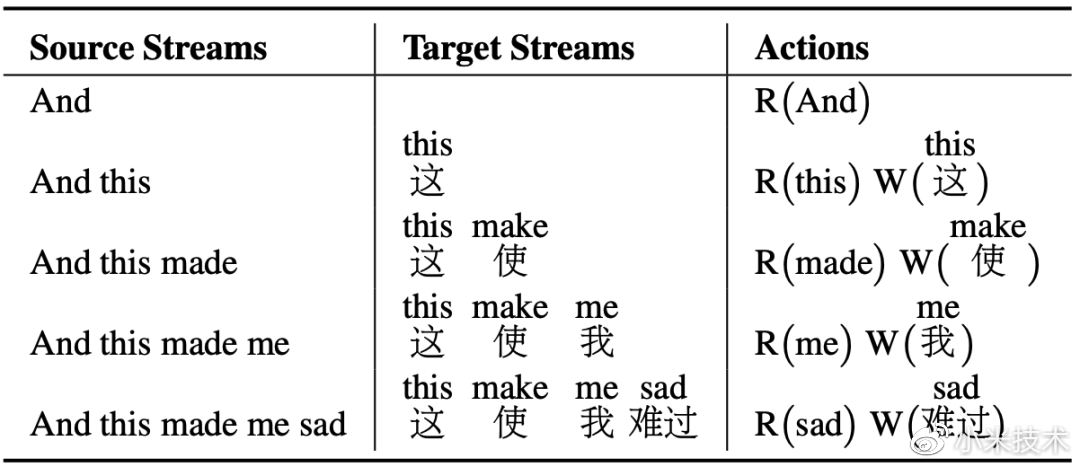

小爱同声传译:双人对话,边说边译,面对面跨语言沟通无障碍,能轻松应对全球多个国家的不同英文口音。

【论文简介】

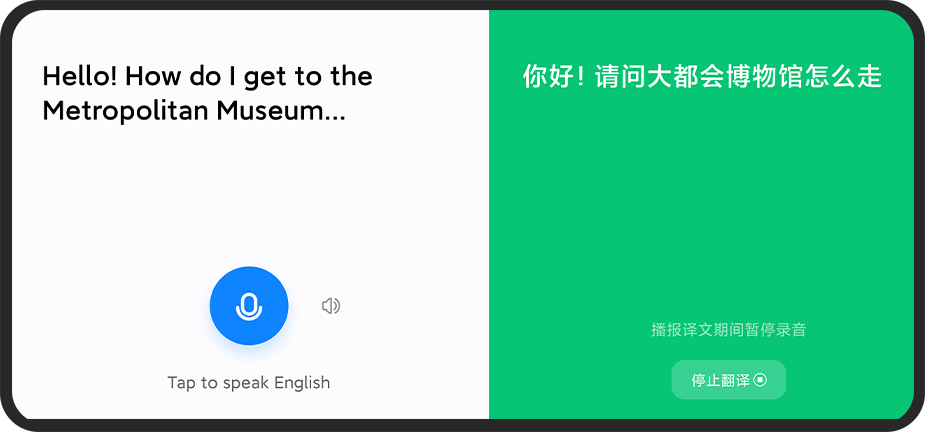

AI同传任务为了保证译文生成的实时性,必须在没有看到整个源语言句子的情况下生成翻译,而目前大多数AI同传模型都是在整句翻译测试集上进行评估的。这让我们重新思考:用现有的整句翻译测试集来评估AI同传模型的质量和延时是否合理?我们分别基于两个主流AI同传模型对比不同延迟或刷新率条件下自动评价和人工评价的变化趋势,结果如下:

其中AL表示Wait-k模型的延迟,NE表示Re-trans模型的刷新率,BLEU分数是译文质量的自动评价指标(越大质量越高),AP作为人工评价指标用于评估译文的可接受度(越大质量越高)。我们惊讶地发现,随着翻译延迟或刷新率的降低,人工评分下降率仅为13~14%,远低于BLEU分数的下降幅度。这表明整句翻译测试集确实低估了AI同传模型的能力。

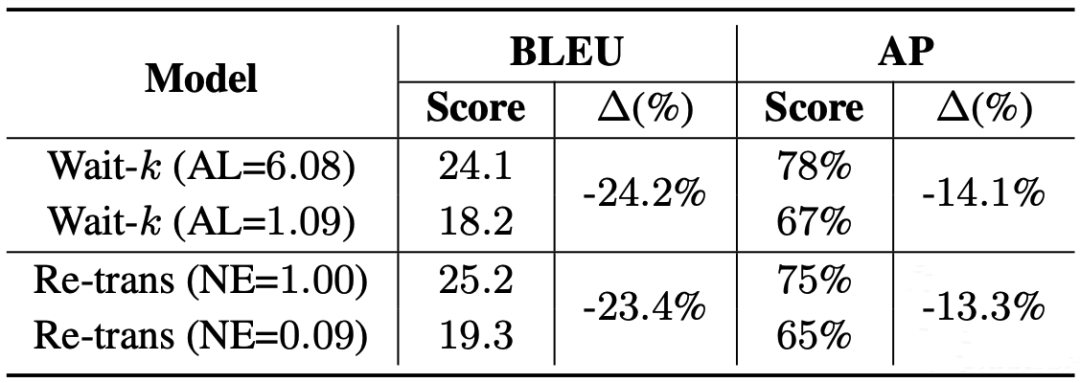

本文主要贡献是提出了首个名为SiMuST-C的机器同传专用英中测试集,后续我们计划开源该数据集,为相关研究提供更合理的评价工具。该测试集是基于MuST-C英中测试集以流式方式所标注,流式标注过程如下表:该例子经过五步完成标注(其中R和W分别表示读和写操作,括号中表示标注人员每步读或写的内容)。

实验表明标注测试集与MuST-C英中测试集的可接受度相当,并且缓解了现有测试集对同传模型的低估问题,更加适合作为同传模型的测试集。此外,我们定义一个基于对齐的单调性指标,并使用该指标从训练集中自动抽取单调数据,使用该单调数据微调AI同传模型,可以在低延迟下提升多达3个BLEU值。

02

▍Joint Training and Decoding for Multilingual End-to-End Simultaneous Speech Translation

Wuwei Huang,Renren Jin,Wen Zhang,Jian Luan,Bin Wang,Deyi Xiong

【论文简介】

端到端语音翻译(End-to-End Speech Translation)近期取得了突破性进展,当训练数据达到一定规模时,端到端语音翻译的质量已经可以媲美级联(先做语音识别,再做机器翻译)的方法。这些进展激发了研究人员对多语言端到端语音翻译和端到端语音同传的兴趣。

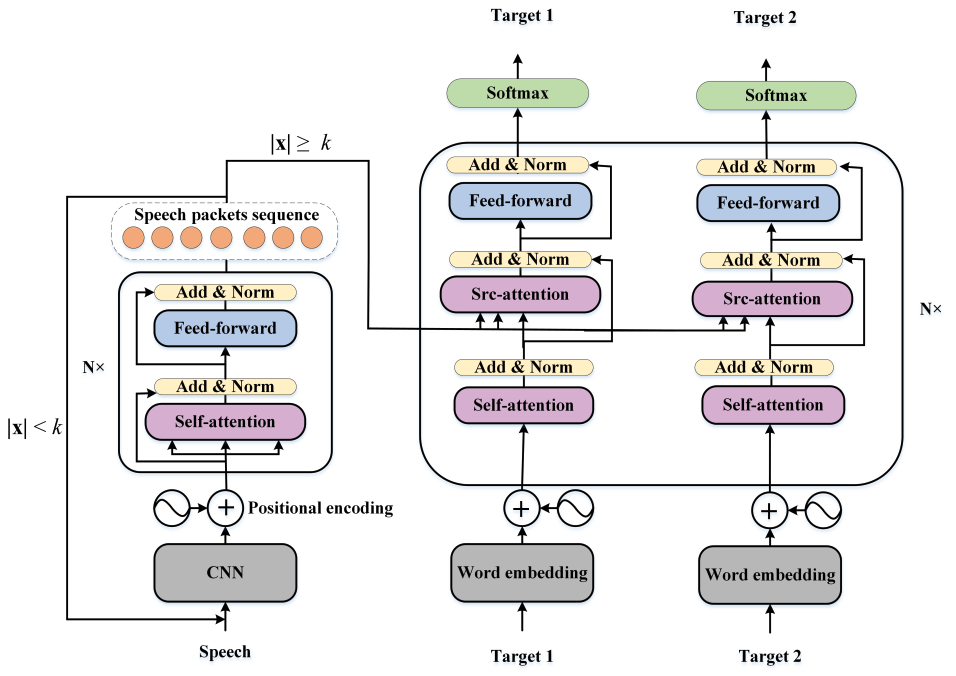

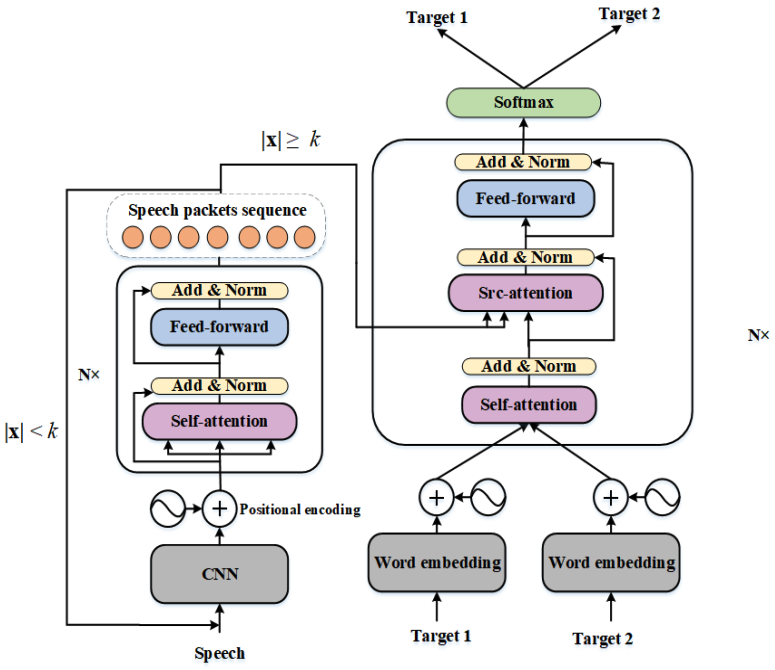

本文从多语言端到端语音翻译与端到端语音同传结合方面展开,提出用于联合同步训练策略的双解码器框架和单解码器统一这两个多语言端到端语音同传的模型变体框架。该框架可以实时地将一种源语言对应的语音同时翻译成多种目标语言的文本,主要验证了其优于双语语音同传的方法,同时为相关研究团体提供一个很有潜力的研究方向。为了进一步探索跨语言的知识转移,我们基于单解码器统一框架又提出了一种异步训练策略。两个模型框架分别如下图示:

(a)双解码器框架

(b)单解码器统一框架

使用gentle和Laser对齐工具构建一个多路对齐的多语言端到端ST测试集,用于评估我们所提出的方法。实验结果表明当使用同步训练策略时,所提出的两个模型框架均显著优于双语的语音同传模型;另外,在单解码器统一框架上的异步训练策略又进一步带来了提升。这与多语言翻译模型上的结论一致,不同语种之间有相互促进作用。

03

▍Delay-penalized transducer for low-latency streaming ASR

Wei Kang,Zengwei Yao,Fangjun Kuang,Liyong Guo,Xiaoyu Yang,Long Lin,Piotr Żelasko,Daniel Pove

【论文简介】

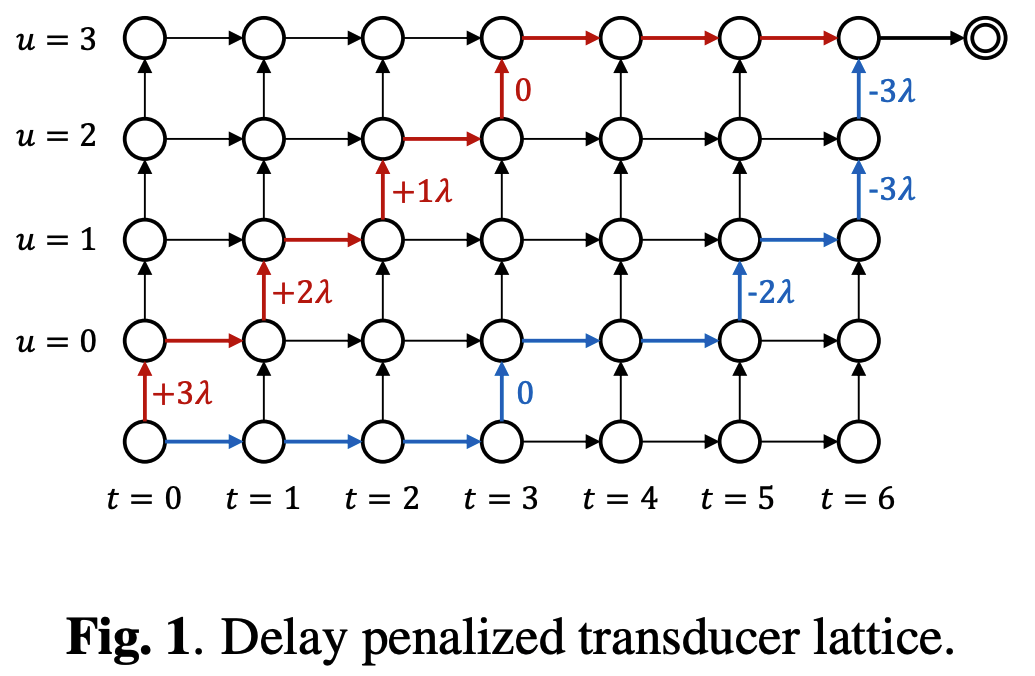

端到端流式语音识别任务中,一般认为模型只能看到有限的上下文信息,所以总是会带来一些识别的时延。尽管已经存在一些方法可以降低这个时延,但是它们通常需要依赖于额外获取的时间对齐数据。

本论文中,我们提出一个简单的方法用于惩罚 Transducer 模型的时延,可以调节流式模型在准确率和时延之间的 trade-off。具体而言,在利用动态规划算法计算 Transducer 目标函数之前,我们在非 blank 的 log-probabilities 上加一个常数 λ 乘以 (T/2 - t),其中 T 是帧数,t 是当前帧索引。实验结果表明,在流式 Conformer 模型和 LSTM 模型上,该方法可以在降低可接受的准确率情况下,有效降低识别时延。我们的方法取得了与 FastEmit 相似的准确率-时延 trade-off,但是具备更强的理论可解释性:其相当于惩罚整个 Transducer lattice 的平均时延。

相关代码已开源,可点击此链接跳转使用:https://github.com/k2-fsa/k2

04

▍PREDICTING MULTI-CODEBOOK VECTOR QUANTIZATION INDEXES FOR KNOWLEDGE DISTILLATION

Liyong Guo,Xiaoyu Yang,Quandong Wang,Yuxiang Kong,Zengwei Yao,Fan Cui,Fangjun Kuang,Wei Kang,Long Lin,Mingshuang Luo,Piotr Żelasko,Daniel Povey

【论文简介】

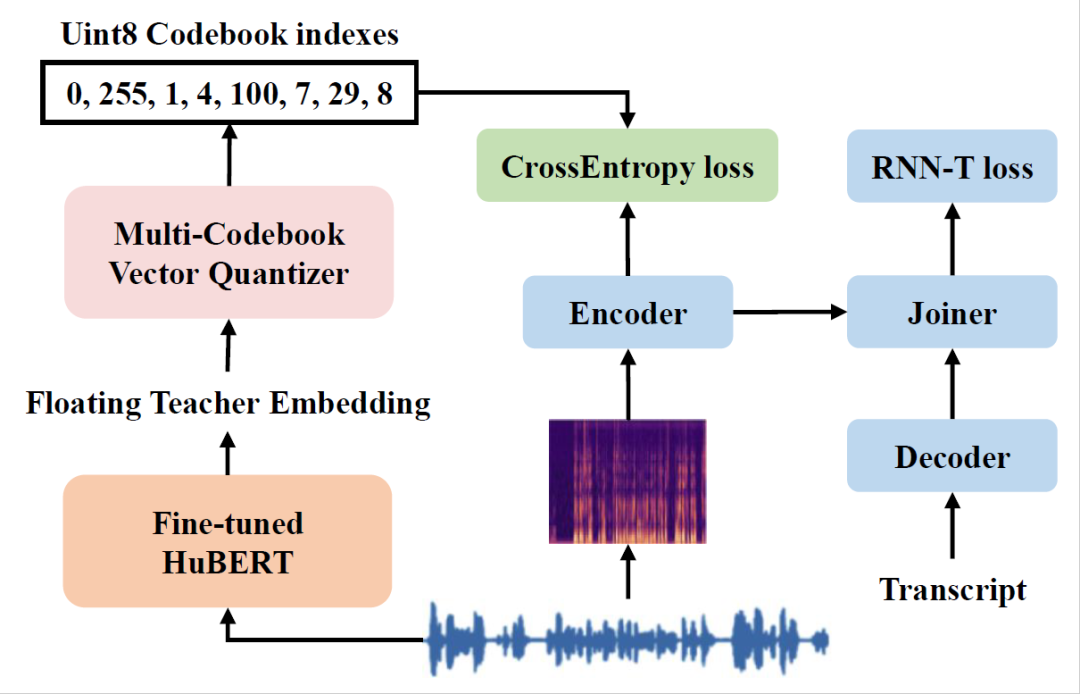

在自动语音识别(ASR)中,知识蒸馏(Knowledge Distillation, KD)是一种常见的提升模型表现的手段。传统的 KD 框架中,学生模型通过学习教师模型生成的标签来提升自己的表现。然而,传统 KD 框架面临着存储空间和训练效率两个问题:

1. 将所有生成的标签(通常是浮点向量)全部存储下来所需要的空间巨大,并不适用于大型数据集(上万小时)。

2. 在线推理教师模型并生成标签能够节约存储空间,但是增加了训练的时间成本,并且影响训练时最大可用的 batch-size。

针对现有 KD 框架的上述两个痛点,本文创新性的提出了一种量化算法(Multi-vector Quantization, MVQ)。使用 Direct-sum codebook 办法将浮点向量格式的教师标签压缩成 N 个 8-bit 的编码索引(codebook index,CI),并且提出了一套高效的编码索引优化策略,尽可能缩小重建误差。通过控制N的大小,MVQ 算法能够实现不同精度的向量压缩。

同时,基于 MVQ 算法,也提出了一套高效的知识蒸馏方案 MVQ-KD:在进行KD训练时,提取学生模型中间层的Embedding用于预测 MVQ 对教师 Embedding 编码后得到的CI,使用交叉熵损失函数和RNN-T损失函数进行多任务学习。

实验表明,MVQ-KD 能够在实现对教师模型标签的256倍压缩率的同时,将学生模型的词错误率降低约10%。与传统的基于L1或L2损失函数的蒸馏方案相比,大幅度减少了存储教师模型标签所需的空间,且没有明显的性能损失,有效的解决了传统知识蒸馏方案的痛点问题。

相关代码已开源,可点击此链接跳转使用:https://github.com/k2-fsa/k2/icefall

05

▍Fast and parallel decoding for transducer

Wei Kang,Liyong Guo,Fangjun Kuang,Long Lin,Mingshuang Luo,Zengwei Yao,Xiaoyu Yang,Piotr Żelasko,Daniel Povey

【论文简介】

高效解码一直是语音识别系统产品化绕不开的课题,在本文中我们设计并实现了在 GPU 上实现高效FSA 解码的方案,为此我们对 RNN-T 做了一些改造。

1. 在RNN-T中使用了无状态的decoder网络,使用有限的left context。

2. 在解码时限制每一帧语音只能输出一个symbol。

在这两个前提下,又基于 k2 中的 RaggedTensor 实现了帧同步的 beam search 解码。这可能是现今唯一既能使用 FSA 又能运行于 GPU 的解码方法,通过测试我们发现使用 80M 的模型在英伟达 V100 显卡上能并行跑 200 路以上的语音,LibriSpeech 数据集上的解码实时率低至 0.0025。

核心代码实现开源在https://github.com/k2-fsa/k2 (搜索rnnt_decode.{h,cu}),应用示例开源在https://github.com/k2-fsa/icefall (搜索fast_beam_search)。

06

▍Unified Keyword Spotting and Audio Tagging on Mobile Devices with Transformers

Heinrich Dinkel, Yongqing Wang, Zhiyong Yan, Junbo Zhang,Yujun Wang

【论文简介】

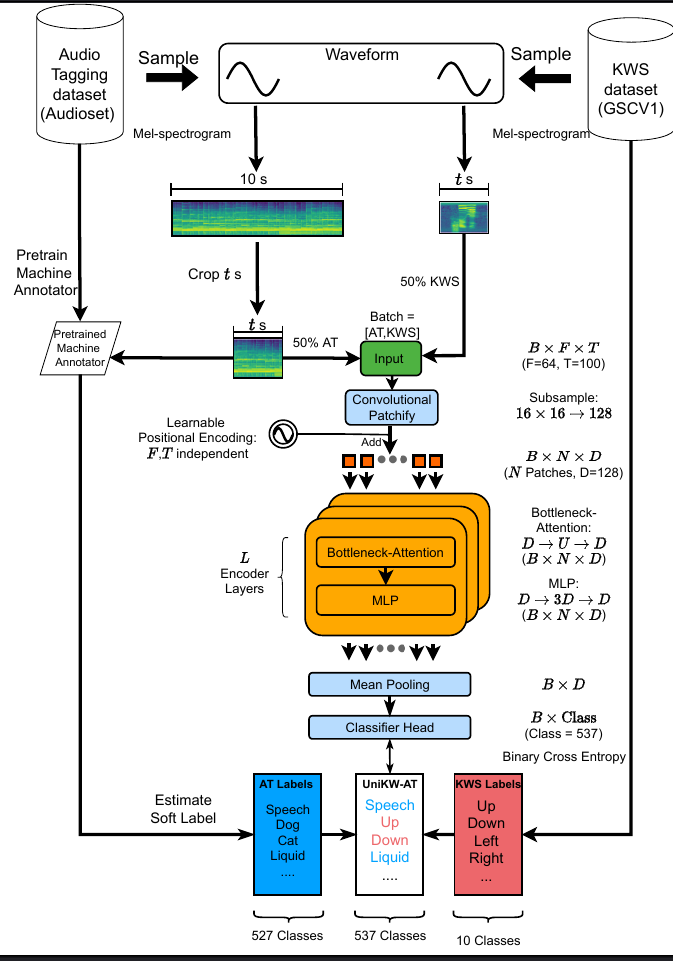

UniKW-AT(联合语音唤醒和音频标记),一直是我们在持续研究的课题。去年,我们研究的Interspeech论文(链接:https://arxiv.org/pdf/2209.11377.pdf) ,首创性的提出了UniKW-AT框架。这是一种将语音唤醒(KWS)和音频标记(Audio Tagging)相结合的统一框架,其目的是在设备端进行部署这两个功能时可以节省资源消耗以及提高唤醒模型在噪声下的鲁棒性。然而,这部分的研究并未考虑到UniKW-AT模型在实际部署中的因素,例如模型大小和推理速度等因素。因此,今年本篇论文将持续探索发展的可能性,具体流程详见下图:

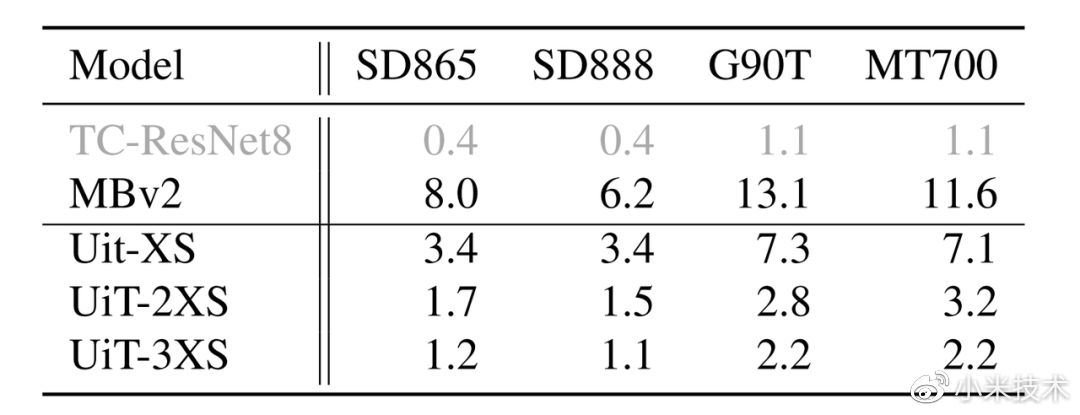

所提出的三种可以部署在移动设备上的模型,称为Unified Transformers (UiT)。实验结果表明,所提出的UiT模型可以在Audioset数据集上达到34.09的mAP和在Google Speech Commands 数据集上达到 97.76的准确度,并且可以在四个移动平台上实现与竞争模型MobileNetV2相比2-6倍的加速。

推理速度测试(耗时毫秒,输入音频1秒)在不同手机(SD865 = 小米10, SD888 = 小米11, G90T = 红米Note8, MT700 = 红米11) 上(音频标记基线 = MBv2, KWS 基线 = TC-ResNet8 ) 结果:

主要使得UniKW-AT这种架构有了可以落地到设备端的可能性。

07

▍AV-SepFormer: Cross-Attention SepFormer for Audio-Visual Target Speaker Extraction

Jiuxin Lin, Xinyu Cai, Heinrich Dinkel, Jun Chen, Zhiyong Yan, Yongqing Wang, Junbo Zhang, Zhiyong Wu, Yujun Wang, Helen Meng

联合 清华大学 吴志勇老师团队、香港中文大学 孟美玲老师团队

【论文简介】

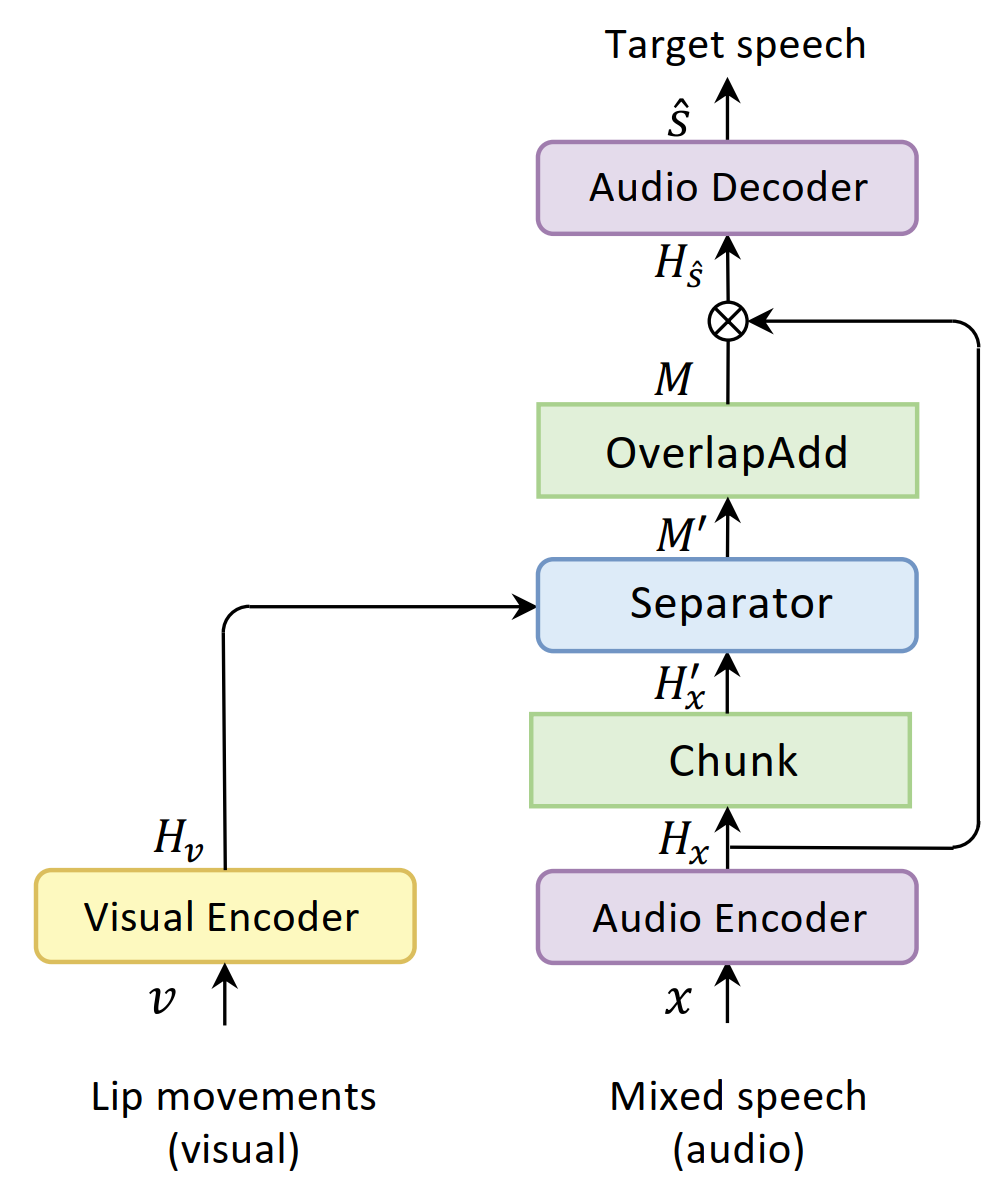

本文介绍了目标说话人提取(TSE)技术,其目标是在多人对话和背景噪声环境中,提取特定人物的语音信号,并在助听器、语音识别、说话人日志、语音监控等领域都有广泛的应用。

相比盲源分离(BSS),TSE方法不受排列不变训练(PIT)的限制,但其需要额外的线索信息来识别目标说话人。其中,唇语运动因为不受背景噪声和混响的影响,比起其他线索如注册说话人语音更具优势。现有的Audio-Visual TSE模型通常会将视觉特征上采样以与音频特征在时间维度上对齐,这样的做法忽略了视觉和音频在时间分辨率上的差异,导致性能下降。

因此,本文提出了一个名为AV-SepFormer的双尺度模型,以更好地融合视觉和音频特征。实验结果表明,该模型在多个数据集上表现出更好的性能。

【论文demo】

https://lin9x.github.io/AV-SepFormer_demo/

08

▍IMPROVING WEAKLY SUPERVISED SOUND EVENT DETECTION WITH CAUSAL INTERVENTION

Yifei Xin , Dongchao Yang , Fan Cui , Yujun Wang, Yuexian Zou

联合 北京大学 邹月娴老师团队

【论文简介】

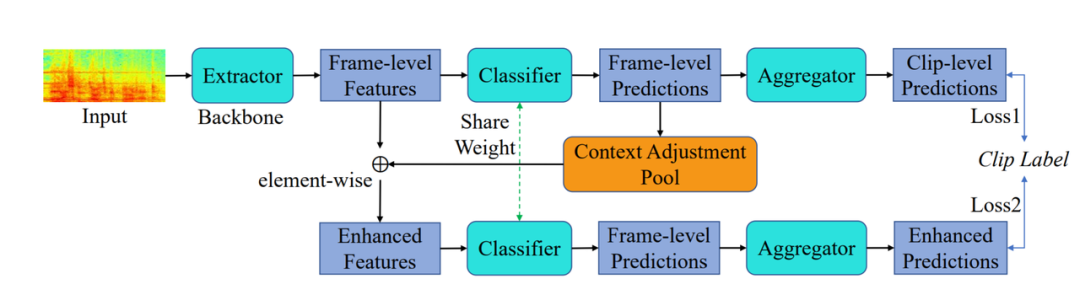

现有的弱监督声音事件检测算法主要关注于同一时间段只有单一事件发生的情况,但实际上同一时间段可能会有多种不同的背景音,所以时间段级别的标注通常是有偏差的。基于此,为了解决上述情况对模型训练的负向影响,本文提出了一种因果干扰(Causal Intervention)来提升弱监督声音事件检测(Sound Event Detection)的方案。

此方法通过迭代累积每个类别可能的上下文信息,然后将累积的上下文信息投影到帧级别特征来消除共现混淆因素的负面影响,使声音事件分类边界更清晰。在多个声音事件检测数据集上的实验表明,此方法能有效地提高了算法检测的正确性。

09

▍总 结

小米AI实验室成立于2016年,覆盖计算机视觉、语音声学、自然语言处理(NLP)、知识图谱、机器学习等多个研究方向。其中,语音团队在语音识别、语音唤醒、声纹识别、口语评测、语音合成、歌唱合成、AI作曲与编曲等方面均取得了重大突破。截至2022年,小爱同学月活跃用户数量为1.15亿,是世界上最忙的语音助手之一。

由小米集团首席语音科学家、Kaldi 之父Daniel Povey 牵头组建的“新一代 Kaldi”研发团队,重点研究包括新的声学编码器、半监督及无监督训练、高效的解码方法、大模型训练等技术,将语音识别准确率推上一个新台阶,并持续赋能小米语音产品。

在自然语言处理(NLP)领域,研究的内容主要包含人机对话、机器翻译、机器写作、舆情分析等技术。目前,小米自研机器翻译技术已广泛落地应用于小爱翻译、小爱同学、AI通话助手、浏览器、传送门、笔记、扫一扫等小米手机软件产品,以及小爱老师学习机、小爱音箱、小爱鼠标、米兔手表、小米手环、米家眼镜相机等智能硬件产品,月活跃用户数超千万。此次成绩的取得,离不开小米工程师们在实际业务中扎实的技术积累,同时也是小米坚持“技术为本”理念的有力印证。未来,小米将继续探索科技新高度,让更多人享受科技带来的美好生活